Probleme in der Wissenschaft

Was will die Wissenschaft

Studien sollen Fragen beantworten, deren Antwort wir bisher nicht kennen.

Leider häufig

Studien sollen Belege für bereits bestehende Überzeugungen liefern.

Signifikanz / p-value

Gängiges vorgehen: p < 0,05 gilt als "statistisch signifikant."

Bedeutet unter Idealbedingungen: Bei 20 Studien zu nichtexistenten Effekten ein positives Resultat.

Higgs-Boson: 5 sigma

In p-Value umgerechnet: 0.0000003

p<0,05 - gut genug?

Nach 20 Studien kann es zu einem falsch-positiven Ergebnis kommen - klingt erstmal nicht so schlecht.

Studien mit negativem Ergebnis werden meistens nicht publiziert!

Publication Bias

Was in der wissenschaftlichen Literatur auftaucht ist nur ein Bruchteil dessen was tatsächlich durchgeführt wird.

Publication Bias und Antidepressiva

- 74 Studien über sogenannte SSRIs, Daten von der FDA.

- 37 von 38 Studien mit positivem Resultat wurden publiziert.

- 14 von 36 Studien mit negativem Resultat wurden publiziert (davon 11 mit verzerrter Zusammenfassung).

Publication Bias - was tun?

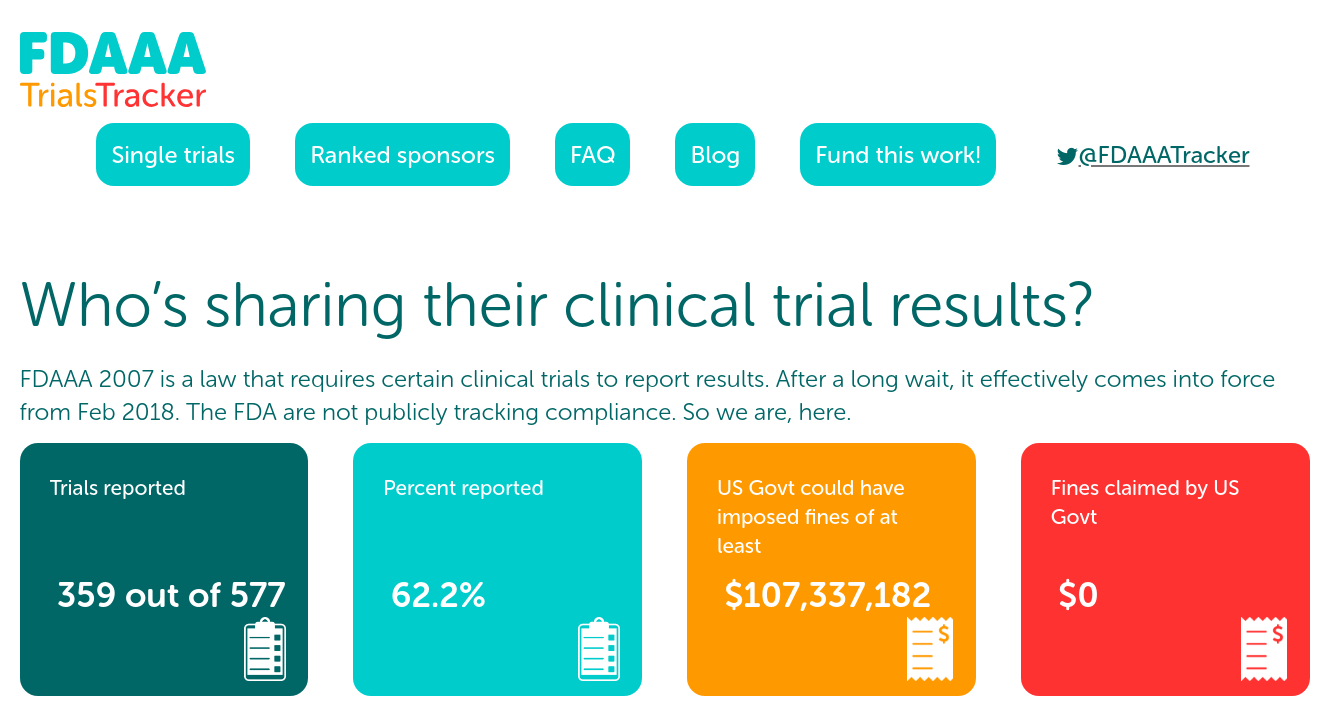

Studienregister / Preregistrierung

Studienregister

Studien werden *vor* ihrer Durchführung in einem öffentlichen Verzeichnis eingetragen.

"Verschwindenlassen" von Studien kann entdeckt werden.

Bei Medikamentenstudien sind Studienregister inzwischen meistens (theoretisch) vorgeschrieben und müssen auch publiziert werden.

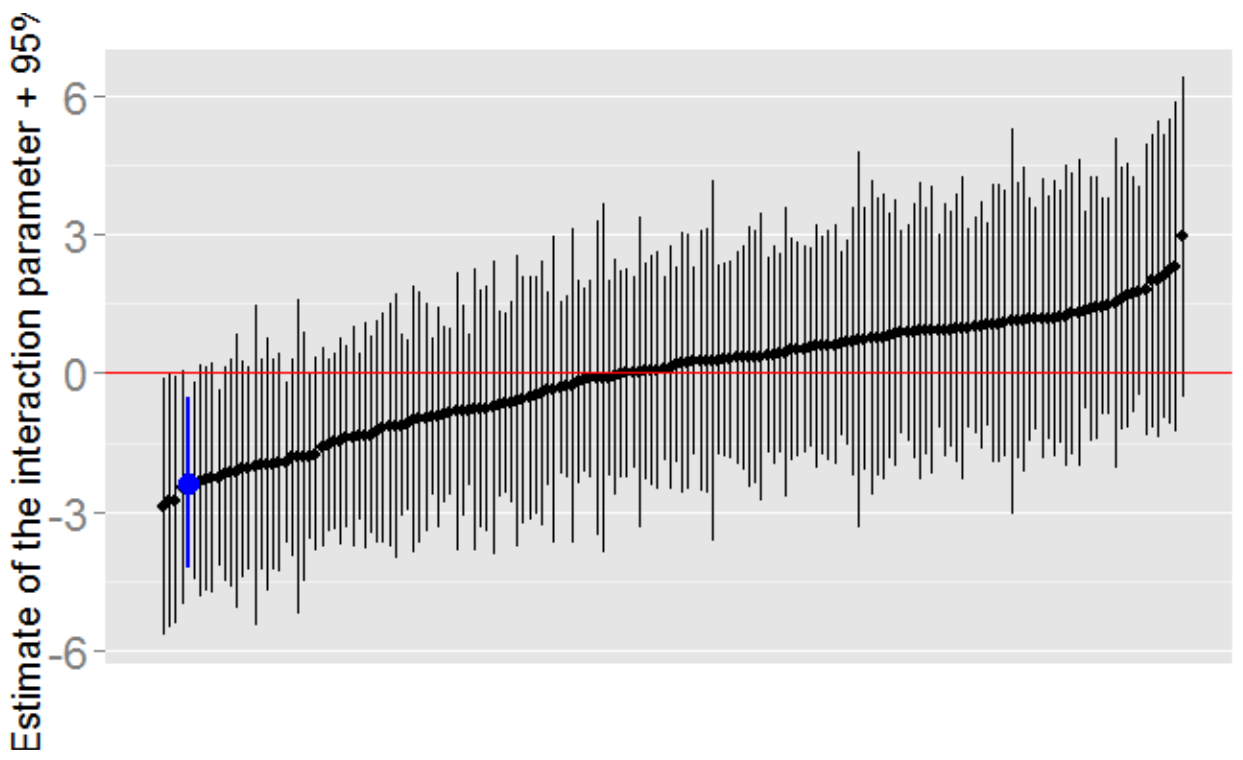

Outcome Switching

Publizierte Studien stimmen nicht mit Preregistrierung überein.

Publication Bias ist kein Problem der Medizin

Preregistrierung bei Medikamentenstudien funktioniert mittelmäßig.

Dabei aber bedenken: In vielen wissenschaftlichen Bereichen wird das Problem "Publication Bias" schlicht ignoriert.

Registered Reports

Idee geht noch etwas weiter als Preregistrierung.

Vor der Studie wird ein Studiendesign ("Registered Report") publiziert und bei einem Journal zum Peer Review eingereicht.

Journal entscheidet *vor* Durchführung der Studie, ob sie publiziert wird.

p-Hacking

Bei der Analyse von Daten gibt es immer kleine Entscheidungen, die Einfluss auf das Ergebnis haben ("degrees of freedom").

Wissenschaftler können - oft unbewußt - immer die Entscheidung wählen, die zu einem gewünschten Ergebnis führt - und damit oft gerade so die Signifikanzschwelle überschreiten.

Fragwürdig ob man solche Studien überhaupt durchführen sollte

Was bedeutet das?

Replikationskrise

Bem played by the implicit rules that guide academic publishing. In fact, Bem presented many more studies than would usually be required. It would therefore be mistaken to interpret our assessment of the Bem experiments as an attack on research of unlikely phenomena; instead, our assessment suggests that something is deeply wrong with the way experimental psychologists design their studies and report their statistical results.

Lesenswerter Longread:

Replication Project: Psychology

Nur 39 von 100 Studien konnten bestätigt werden.

Viele Effekte in der Psychologie, die als etabliert galten, wurden durch Replikationen in Frage gestellt (z.B. Social Priming).

Präklinische Krebsforschung

2012: Amgen publiziert Kommentar in Nature, dass in firmeninternen Studien nur 6 von 53 wichtigen Papers repliziert werden konnten.

Ähnliche Aussagen von anderen Pharmafirmen (Bayer).

"It's complicated"

Replikationen wurden zunächst nicht veröffentlicht, später nur 3 Studien.

Reproducibility Project: Cancer Biology

Resultate teilweise publiziert, in mehreren Fällen konnten die Studien nicht nachvollzogen werden.

Machine Learning / "Artificial Intelligence"

Alles Mist - Schlussfolgerungen?

Einzelstudien sollte man generell nicht als Belege, sondern höchstens als Hinweise sehen.

(Ausnahmen sind nur sehr große Studien mit überdurchschnittlich guter Methodik.)

Preregistrierung ist ein wichtiges Merkmal für hochwertige Studien.

(Aber in vielen Fachgebieten völlig unbekannt.)

Anreize

Wissenschaftler müssen publizieren - am besten in großen Journalen

Impact Factor

Eine (proprietäre) Maßeinheit, wie häufig ein Journal zitiert wird.

Publikation in "High Impact Factor"-Fachzeitschriften gilt als Erfolg.

Impact Factor

Der Impact Factor misst die Beliebtheit einer Studie, nicht die Qualität.

Anreiz zu: Spektakulären Ergebnissen, Medienresonanz, Kontroversen.

Kein Anreiz für: Komplexe, schwer interpretierbare Ergebnisse, publikation negativer Resultate.

Hoher Impact Factor - schlechtere Wissenschaft?

Tatsächlich gibt es dafür einige Belege.

Schlussfolgerungen

- Große Teile der Wissenschaft haben ein massives Problem mit Qualität und Reproduzierbarkeit.

- Es gibt mehr falsche als korrekte Studienergebnisse.

- Nicht replizierte Einzelstudien sollte man im Normalfall nicht als Belege heranziehen (und in der Regel auch nicht darüber berichten).

Schlussfolgerungen

- Hinweise auf bessere Qualität: Preregistrierung, Studiengröße, Replikationen.

- Kein Hinweis auf Qualität: Große Journale, Impact Factor.